Portlandで開催されたHashiConf 2015に参加してきました。

Day 1

Keynote

Founder & CEOのMitchell Hashimotoが登壇。 今までのHashiCorpプロダクトを紹介した上で、新プロダクトの紹介!

コンテナスケジューラ。ちょうどあるサービスの一部のDocker化でスケジューリング方法を考えていたので、グッドタイミング。

開発からデプロイまで対応したmicroservicesを念頭に入れたVagrantの後継。

Operating Consul as an Early Adopter

- 初期の頃からconsulを運用した苦労話

- v0.2から始めた

consule-template- スケールしない。v0.6ではマシに

- 大きいクラスタで自身をDDOSする

- watchesを使わないでcronで

-once

- consulのDNSが不安定な時期があったので、15秒毎にzone fileを書き出し内部DNSで運用

- その他初期バージョンで諸々不具合を発見してArmonと一緒に修正

- ご苦労様

HashiCorp Tools in the Modern Enterprise

- エンプラだって頑張ってDevOpsしてるもん!

- 文字多めで眠くなっちゃった。。

- Izanamee イザナミ?

Resillient Infrastructure with Serf

- Pagerdutyの人

- SerfとChefと自社ツールを組み合わせて堅牢なインフラを構築

- Blender - a modular remote command execution framework

- SerfX - a bare minimum ruby client for serf

Genesis: Terraforming a new Firefox crash stat infrastructure

- Mozillaの人達による漫才ベースのプレゼン

- Firefoxのクラッシュ統計データを受信するインフラの構築について

- 結構笑いがとれてた

The future of management, and how we’ll get there

Puppetの作者Lukeさん。未来に観するディープで知見溢れるトーク

Day 2

Keynote

HashiCorpの哲学とAtlasの説明(2日目は新製品の発表はなし)

Dockerizing all the Things

- Docker社内でのCIでconsul使ってるよって話

- あまり面白くなかった

- 20分も残して終了。。

Automate your Infrastructure

以下のツールでいろいろ自動化してるよ(フーン)

- Terraform

- CircleCI

- Docker (ECS)

- Datadog

- Slack

Managing Applications at Scale

- CoreOSの人

- Nomad vs Kubernetes

- CLI demo

Repeatable, Extensible Infra at Yelp

- YelpのSite Reliability Engineer

- 内部ツールで起動、puppetでプロビジョニング

- Packerやpuppet managed VPCだったけど、今はTerraform

- Smartstack (Service discovery)

- Nerve

- Synapse

- Hacheck

- qdisc_tools

- Sensu

- nsone

- terraform community modulesをたくさん書いたよ

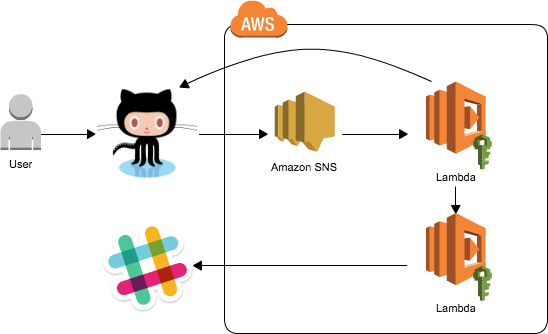

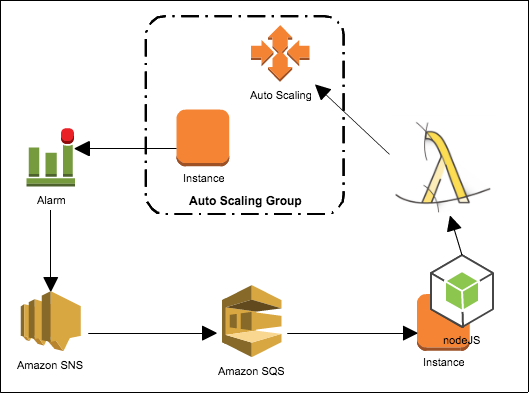

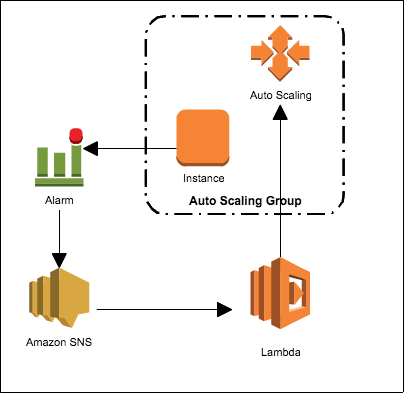

Virtual Machines, Containers, Lambdas? Oh my!

- AWSの中の人(DevOps担当)

- Microservicesについて

- 導入の判断基準

- VM(EC2, Packer, Terraform/Cloudformatio, Consul)

- Container (ECS, Nomad)

- Lambda (サーバレスアーキテクチャ。例:SquirrelBin

- さらっと自社サービスをたっくさん紹介した後、結論はLambdaとAPI Gateway押し

- そんなにサービスを詰めこめなくても。。

感想

Nomadの発表が一番エキサイティングだったけど、こういうカンファレンスは中の人やスピーカーや他のユーザーと直接話せるのが醍醐味。プロダクトの担当者に直接フィードバックを伝えたり、展望を聞いたりできて楽しかったです。また、会場で話した参加者も多種多様でアメリカ以外だとスペイン、オーストラリア、ニュージーランド、インド、日本等がいて、世界中から注目されている感じでした。

第一回目ということで約300人の中規模だけど、このぐらいが皆の距離感近くて良い雰囲気。

その他

- 懇親会で飛び込みLTしたかったが会場設備が対応できなく、断念

- Portland心地良くて過ごしやすい!

- 記念にもらったHashiCorpとハシ(箸)をかけたジュークは誰も理解してなかった (Mitchellが言うには日本人参加者が理解してくれるから良いんだと)

さて、来週はre:Inventだ!